Partido de especialistas em IA elege 11 deputados no Japão

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/202625/09/2025

Por Ricardo Marques da Silva

Já se sabe que algumas pessoas estão usando os chatbots de IA para consultas relacionadas à saúde mental, uma prática que geralmente é desaconselhada, pelos riscos envolvidos. Agora, um artigo publicado pela MIT Technology Review, a revista do Instituto de Tecnologia de Massachusetts, levou a questão a outro nível ao mostrar que terapeutas norte-americanos vêm recorrendo secretamente ao ChatGPT para tratar seus pacientes.

Assinado pela jornalista de tecnologia Laurie Clarke, o artigo cita casos como o de Declan, de 31 anos, que mora em Los Angeles e não teve o sobrenome revelado, que descobriu o problema por causa de uma falha técnica. Ele estava em um consulta online, a conexão ficou instável e, de repente, o terapeuta compartilhou sua tela, sem querer. “Foi quando vi ele usar o ChatGPT. Ele estava pegando o que eu estava dizendo e colocando no ChatGPT, e então resumindo ou escolhendo respostas”, disse Declan.

Para ele, foi um choque. “Durante o restante da sessão, Declan ficou observando uma transmissão em tempo real da análise do ChatGPT se espalhando pela tela do seu terapeuta. Tudo ficou ainda mais surreal quando Declan começou a ecoar o ChatGPT em suas próprias respostas, antecipando seu terapeuta”, relatou o artigo. Na sessão seguinte, ele cobrou o terapeuta, que chorou. “Foi muito constrangedor, com um término estranho. E eu ainda fui cobrado pela sessão,” diz Declan, com bom humor, mas decidido a procurar outro profissional.

Outra paciente – Hope, de 25 anos, que vive na Costa Leste dos Estados Unidos – passou por experiência semelhante. Ela havia enviado uma mensagem direta para sua terapeuta sobre a morte do seu cachorro e logo recebeu uma resposta atenciosa, se não fosse uma referência ao prompt da IA preservado acidentalmente no topo: “Aqui está uma versão mais humana, sincera, com um tom gentil e conversacional”. Hope ficou surpresa e confusa: “Foi uma sensação muito estranha. Depois comecei a me sentir meio traída, e isso definitivamente afetou minha confiança nela”, disse.

Segundo o artigo, a terapeuta se desculpou e explicou que, como nunca teve um animal de estimação, recorreu à IA para ajudar a expressar o sentimento apropriado. Mas Hope não se convenceu e definiu a situação como “especialmente problemática”, porque parte do motivo de procurar terapia estava ligada a seus problemas de confiança.

A matéria da MIT Technology Review entrevistou outros pacientes em situações parecidas, ouviu alguns especialistas e citou estudos científicos que abordaram essa questão. Também destacou que o uso de chatbots nessa tarefa não é autorizado pelas agências reguladoras, assim como a divulgação de informação pessoal ou de saúde para uma IA. Todos concordam que o tema é delicado e envolve uma grave violação da ética e da privacidade, e o uso de chatbots por terapeutas tem o potencial de expor dados sensíveis e comprometer a confiança e a segurança dos pacientes.

#chatbots de IA#ChatGPT#dados sensíveis#privacidade#saúde mental#terapeutas

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/2026

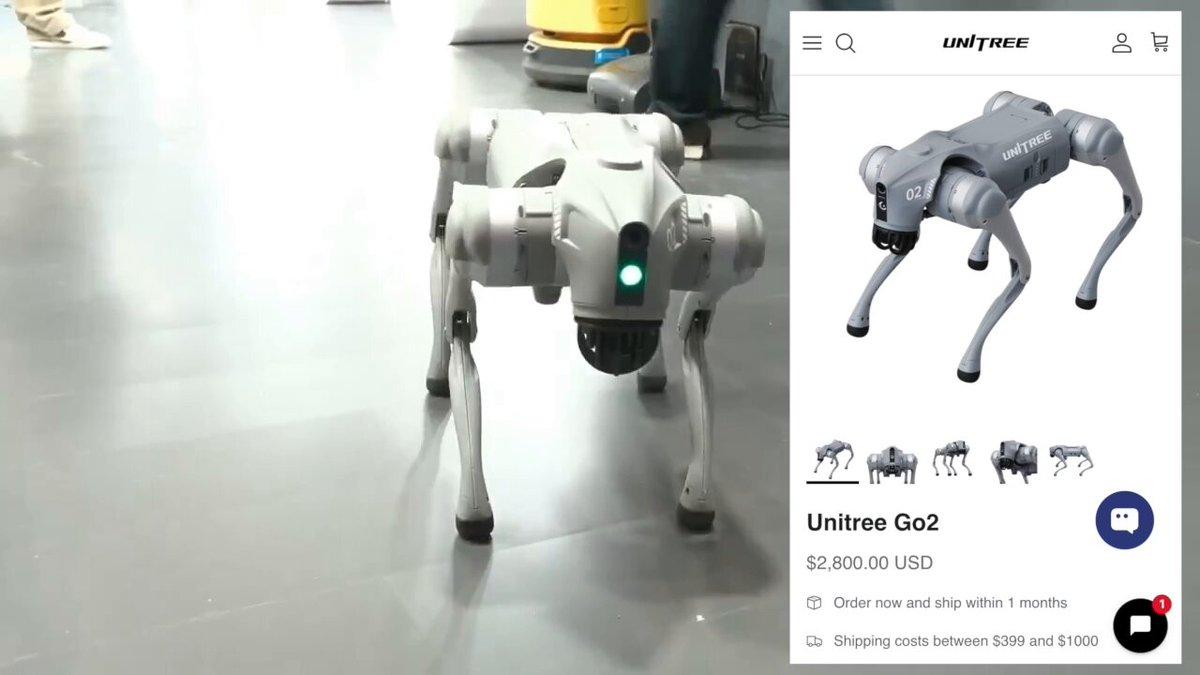

Direção do AI Impact Summit despejou a Galgotias quando uma professora apresentou um cão-robô chinês como se fosse uma invenção própria

23/02/2026

Empresa ampliou a eficiência operacional em processos críticos e a precisão dos dados financeiros

20/02/2026