Partido de especialistas em IA elege 11 deputados no Japão

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/202613/04/2023

Por redação AIoT Brasil

A preocupação mundial com os limites do uso de ferramentas de inteligência artificial generativa ganhou uma abordagem prática nos Estados Unidos, e o Departamento de Comércio do país anunciou nesta semana que vai colher opiniões para estabelecer regras e limites para bots como o ChatGPT, o Bing e o Bard. A intenção é buscar ajuda para que os formuladores de políticas norte-americanos possam criar uma espécie de código de responsabilidade para a utilização da tecnologia.

Em entrevista ao jornal britânico The Guardian, Alan Davidson, chefe da Administração Nacional de Telecomunicações e Informações (NTIA) do Departamento de Comércio, disse que estão buscando um feedback do público e de pesquisadores, grupos da indústria e organizações de privacidade e direitos digitais para o planejamento de auditorias e avaliações de ferramentas de IA.

“Da mesma forma que as auditorias financeiras criam confiança na precisão de suas demonstrações para as empresas, os mecanismos de responsabilidade da IA podem ajudar a garantir que os sistemas sejam confiáveis”, explicou Davidson. “Temos de nos mover rapidamente, porque essas tecnologias de IA estão avançando muito depressa em alguns aspectos”, acrescentou.

Um dos objetivos da regulação, segundo Davidson, é estabelecer barreiras que permitam ao governo determinar se as ferramentas de IA generativa funcionam da maneira como afirmam as empresas que as criaram, se são seguras e eficazes, se respeitam a privacidade dos indivíduos e se contêm um viés discriminatório e espalham e perpetuam desinformação. Nesse nível, foi a primeira reação de um governo à onda de receio que se seguiu ao lançamento do ChatGPT, em novembro do ano passado.

Por enquanto, os chatbots e outros recursos de IA estão sendo desenvolvidos e divulgados sem regras ou estruturas regulatórias, o que permitiu sua rápida expansão e o uso indiscriminado por empresas e pelas pessoas. Agora, aumenta a preocupação com a falta de transparência em relação à maneira como essas ferramentas são treinadas, a ponto de justificar a publicação, em março, de uma carta aberta assinada até mesmo por Elon Musk, cofundador da OpenAI, e Steve Wozniak, cofundador da Apple.

Nesse documento foi proposta a suspensão por seis meses do desenvolvimento de IA generativa, para a avaliação dos riscos envolvidos em sua aplicação. Na União Europeia está sendo discutida uma estrutura legal que categoriza os sistemas de IA por nível de risco: risco inaceitável, alto risco, risco limitado e risco mínimo. Ao aprovar uma lei de inteligência artificial em 2021, a União Europeia se tornou pioneira nessa área, mas tudo indica que com o desenvolvimento das novas tecnologias a legislação já pareça obsoleta.

Na entrevista ao Guardian, Davidson citou as críticas de empresas como a Microsoft à forma de classificação dos riscos e destacou que é justamente por isso que os governos precisam de informações do público para determinar como deve ser uma estrutura regulatória de IA responsável. “Boas proteções implementadas com cuidado podem realmente promover a inovação. Isso permitirá que as pessoas saibam como é inovação positiva e criará espaços seguros para inovar, ao mesmo tempo em que abordam as preocupações reais que temos quanto às consequências prejudiciais”, completou.

#Bard#Bing#bots#ChatGPT#direitos digitais#IA generativa#inteligência artificial generativa#privacidade#regulação

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/2026

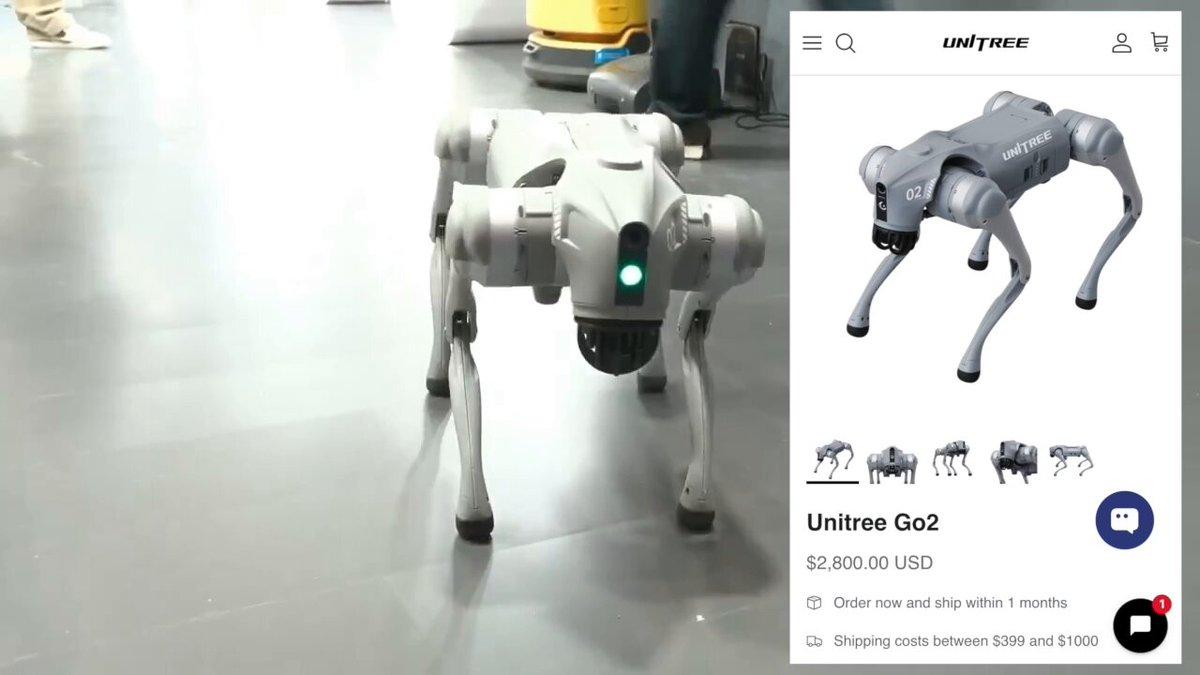

Direção do AI Impact Summit despejou a Galgotias quando uma professora apresentou um cão-robô chinês como se fosse uma invenção própria

23/02/2026

Empresa ampliou a eficiência operacional em processos críticos e a precisão dos dados financeiros

20/02/2026