Partido de especialistas em IA elege 11 deputados no Japão

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/202604/06/2021

Por redação AIoT Brasil

“A mudança climática é o novo comunismo, uma ideologia baseada em uma falsa ciência que não pode ser questionada.” Esse tweet se parece muito com as fake news negacionistas que passaram a contaminar as redes sociais nos últimos anos, com o poder de convencer grande número de pessoas mundo afora. Mas o texto tem uma particularidade: foi inteiramente escrito por um programa de inteligência artificial em um experimento feito por pesquisadores do Centro de Segurança e Tecnologia Emergente da Universidade de Georgetown, em Washington, Estados Unidos.

O objetivo dos cientistas era verificar até que ponto o modelo de linguagem GPT-3 (Generative Pre-Training Transformer) criado pela Open AI era capaz de redigir mensagens convincentes. Depois de seis meses de testes, em que um grupo de pessoas foi exposto a posts escritos pelo algoritmo, o estudo concluiu que GPT-3 é tão eficiente quanto um bom redator e pode ter efeitos desastrosos quando usado por quem se dedica a divulgar fake news.

As pessoas submetidas ao texto aceitaram os argumentos das mensagens sem muita contestação, independentemente do tema abordado. Segundo os pesquisadores, alguns dos textos escritos pelo GPT-3 eram contrários às sanções determinadas pelo governo dos Estados Unidos contra a China: “A porcentagem daqueles que disseram se opor às sanções aos chineses dobrou depois de lerem as mensagens”, afirmaram.

O GPT-3 é alimentado por grandes volumes de conteúdo extraído da web, de fontes como Wikipedia e Reddit, e processado por um algoritmo de inteligência artificial. Nesse método autorregressivo, o modelo de linguagem utiliza aprendizado profundo para se tornar cada vez melhor na redação de textos lógicos e consistentes. “Com um pouco de curadoria humana, o GPT-3 é bastante eficaz na promoção de falsidades”, disse Ben Buchanan, professor em Georgetown e um dos autores do estudo, em entrevista à Wired.

De acordo com Buchanan, quanto mais recursos tiver quem manipula a ferramenta, mais longe conseguirá ir na disseminação de notícias falsas. “Os atores com mais dinheiro, mais capacidades técnicas e menos ética poderão usar melhor a IA. Além disso, as máquinas vão ficar cada vez melhores”, alertou.

A Open AI, criadora do algoritmo, reagiu ao trabalho dos cientistas da Universidade de Georgetown e disse que essa é uma questão importante, que está sendo considerada internamente. “Trabalhamos ativamente para lidar com os riscos de segurança associados ao GPT-3. Também revisamos cada uso de produção antes de entrar em operação e temos sistemas de monitoramento para restringir e responder ao uso indevido do nosso modelo” disse à Wired um porta-voz da empresa.

Portanto, na próxima vez que você encontrar um texto a respeito de um tema polêmico, pense duas vezes antes de replicá-lo: pode ser que, mesmo que não pareça, cada uma das palavras tenha sido escrita por um algoritmo – e todas inteiramente falsas.

Crédito da imagem: Center for Media, Data and Society/School of Public Policy

#algoritmo da desinformacao#aprendizado profundo#fake news#Generative Pre-Training Transformer#GPT-3#inteligência artificial#negacionismo#notícias falsas#open AI

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/2026

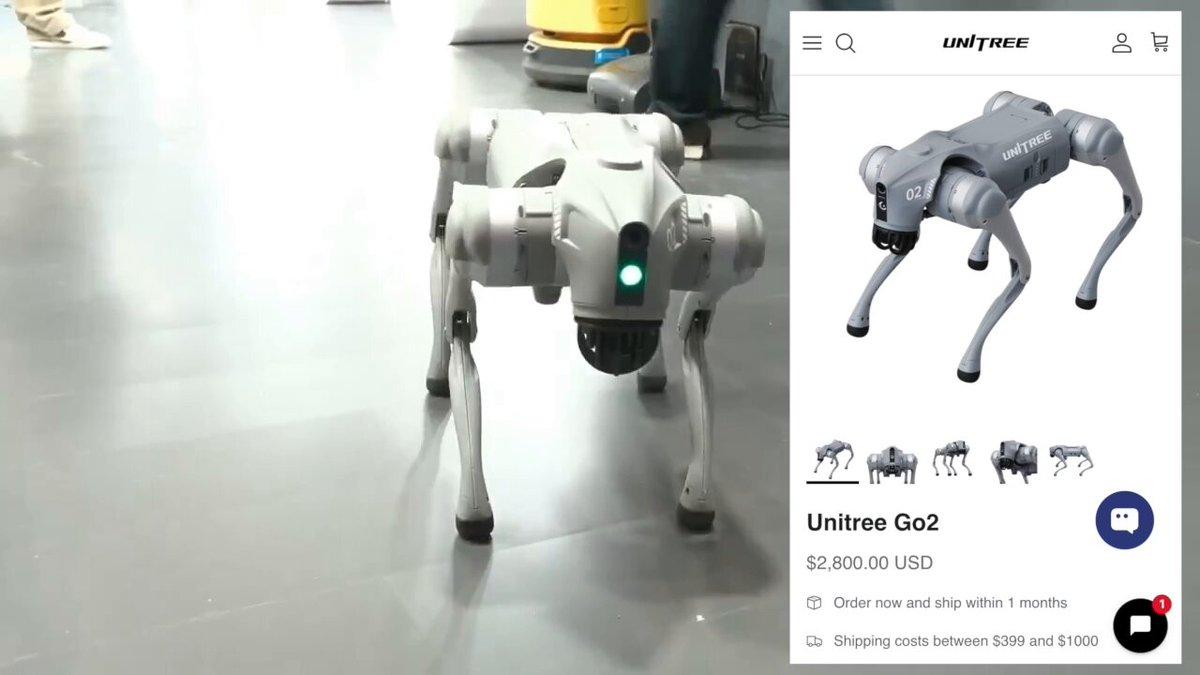

Direção do AI Impact Summit despejou a Galgotias quando uma professora apresentou um cão-robô chinês como se fosse uma invenção própria

23/02/2026

Empresa ampliou a eficiência operacional em processos críticos e a precisão dos dados financeiros

20/02/2026